A Meta anunciou um novo modelo de IA generativa, o Movie Gen, capaz de produzir vídeos, imagens e áudios a partir de texto. Com ele, é possível editar vídeos já produzidos ou fazer de uma imagem um vídeo. É a terceira geração de ferramenta da Meta com esse propósito, e consiste em uma combinação do Make-A-Scene e do Llama Image, primeira e segunda gerações, respectivamente. A partir dos modelos, a big tech acredita que será possível impulsionar o processo criativo de produções multimídia. Em seu comunicado, a empresa deixou claro que a ferramenta não vem com o intuito de substituir artistas, mas de facilitar a produção de visões artísticas, por meio de vídeos e áudios.

O novo modelo da Meta é mais avançado e imersivo, sendo capaz não apenas de gerar vídeo, mas também editar vídeo e gerar áudio. Os testes usaram conteúdos licenciados ou disponíveis publicamente.

Com 30 bilhões de parâmetros, consegue produzir vídeos de até 16 segundos, exibindo um quadro por segundo.

“Descobrimos que esses modelos podem raciocinar sobre movimento de objetos, interações sujeito-objeto e movimento da câmera, e podem aprender movimentos plausíveis para uma ampla variedade de conceitos, tornando-os modelos de última geração em sua categoria”, explicou a empresa.

No modo edição, o usuário pode remover elementos ou mudar o fundo, junto com a produção do vídeo. Segundo a Meta, o Movie Gen tem capacidade de preservar o conteúdo original e focar nos pixels mais relevantes.

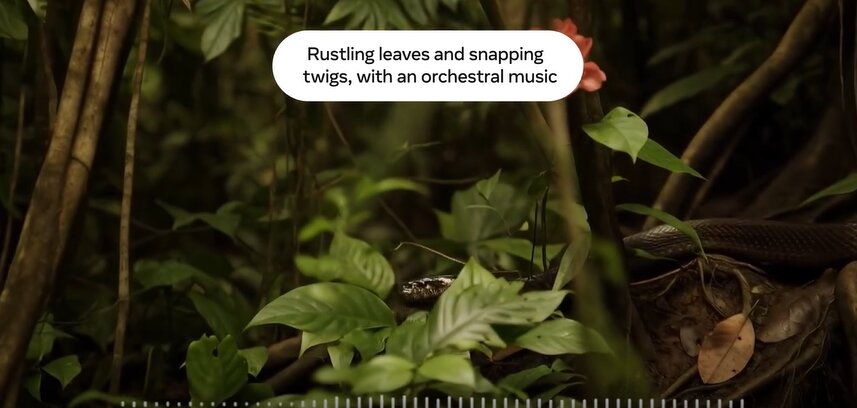

A geração de áudio também é solicitada por texto. É possível gerar áudio de até 45 segundos, com som ambiente, efeitos sonoros e música instrumental de fundo. Também é possível replicar o áudio para vídeos com diferentes durações.

Apesar das novidades, a empresa destacou que os modelos ainda têm limitações, como o tempo de inferência e a qualidade.

Imagem extraída de um dos vídeos da Meta, que demonstra funcionamento da geração de áudio.